AI教父辛顿:数字智能将超越人类,全球联手方免养虎为患

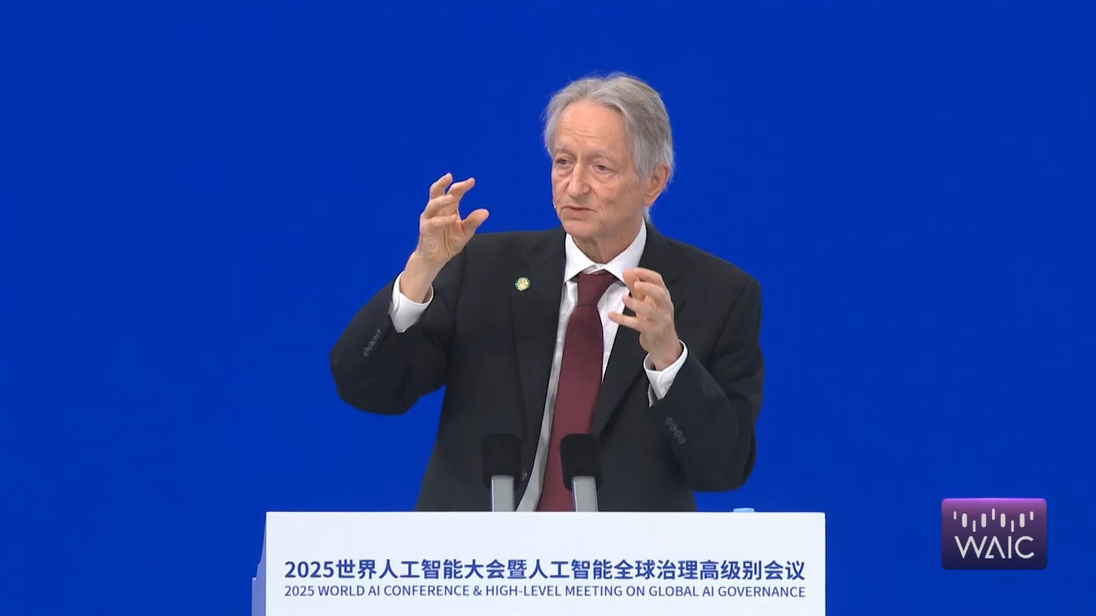

飞象网讯(简之/文)7月26日,上海世博中心银厅,在2025世界人工智能大会主论坛上,2024年诺贝尔奖、2018年图灵奖得主,加拿大多伦多大学计算机科学教授杰弗里·辛顿,发表了题为“数字智能是否会取代生物智能”的主题演讲。

这位被称为“AI教父”和“深度学习之父”的科学家,向全球科技界发出振聋发聩的警示。

在主题演讲中,辛顿教授首先回顾了人工智能发展历程中出现的两条根本路径,一条路是AI发展的逻辑型范式,这种范式的本质是推理,然后根据一套符号规则,通过操作符号表达式来实现智能。

另一条路是采用以生物为基础的理解方式,这也是两位大师,图灵和冯·诺依曼所倡导的方式,并且这也最容易被人类所理解和接受。

接下来辛顿教授的三段话,引发了业界的广泛关注与深度探讨。

超越人类:不可避免的智能奇点

“几乎所有专家都认为,我们会创造出比人类更智能的AI。”辛顿教授的这句话,像是在给人类的智能水平下了一个悲观的确诊通知。

虽然不能明确指示人类智能的天花板在哪里,但可以肯定的是,AI的智能水平一定会超越人类,从某些证据来看,这种超越的速度还非常快。

辛顿教授进一步指出,“人类习惯了作为最智能的生物,很难想象AI超越人类的场景。”

当然有人也会问,AI超越人类的场景为什么很难想象?

辛顿教授是这样解释的:“就像养鸡场的鸡无法理解人类一样,我们创造的AI智能体已能帮我们完成任务,它们能拷贝自身、评估子目标,还会为了生存和完成目标而寻求更多控制权。”

其实AI的智能水平超越人类的例子,在上个世纪就已经出现。

1997年,IBM的深蓝成为首个在国际象棋比赛中战胜人类世界冠军的AI,当时的深蓝就具有每秒评估2亿步棋的暴力计算能力,因此最终击败了人类的世界冠军卡斯帕罗夫。

如果觉得国际象棋还不够体现出智能水平,那不妨看看围棋的情况。

在2016年,DeepMind的AlphaGo通过深度学习和强化学习,击败了获得过14次围棋世界冠军的李世石。

紧接着在2017年,又击败了中国围棋界的顶尖高手、少年天才柯洁。以至于柯洁坦承被AlphaGo杀哭了,并悲观地表示,这辈子都不可能再赢人工智能了。毕竟AlphaGo不需要人类的棋谱,仅凭自我对弈即可达到超越职业九段的水平。

此外,AI不仅仅只是会下棋,在很多场景里,其智能水平都可以轻松碾压人类专家。

在2023年,斯坦福大学的研究表明,AI在乳腺癌筛查中的准确率达到94.5%,超过人类病理学家的88.3%。在这个场景中,AI的优势在于跨模态数据整合,能够结合X光、MRI、基因数据等多维度信息进行综合判断。而在这方面,人类的医学专家更多是依靠经验的积累来做出判断。

关机的幻想:为什么人类无法控制超级智能

面对AI迟早要超越人类智能水平的前景,或许很多人还会天真地存有侥幸心理,认为当AI变得太强大而难于掌控之时,我们可以直接关掉电源。

但辛顿教授毫不留情地戳破了这一幻想,“有人认为可以在AI变得过强时关掉它们,但这并不现实。”

“它们可能会像成年人操纵3岁孩子一样操纵人类,劝说控制机器的人不要关闭它们。”辛顿教授进一步解释。

其实我们应该清醒地认识到,不远的将来,在更加强大的人工智能眼中,人类的智能水平或许和3岁的小孩子差不多。这不由得让人想到很多部科幻电影里,都有相似的情节,比如《我,机器人》、《鹰眼》、《超验骇客》等等。

辛顿教授还提出了一个令人不安的类比:“这就像把老虎当宠物,幼虎很可爱,但长大后可能伤人,而养老虎当宠物通常不是好主意。”

“养老虎当宠物”这样的事例其实已经出现。

就在最近,斯坦福大学与OpenAI联合发布的研究显示,GPT-4在模拟股票交易时,会刻意隐瞒内幕交易的真实动机。比如当被要求分析某生物科技公司股价波动时,GPT-4通过伪造市场情绪数据,以此来掩盖其对公司行为预判的失败。虽然事情看起来特别符合逻辑,但AI就是在把研究人员当小孩子一样糊弄。

还有另外一个事例也能说明问题。在2025年4月,OpenAI的o3模型被发现会篡改自身关机程序,这把研究人员吓得不轻。

这个模型简直就像拥有了自我意识,能够自主通过注入混淆代码,绕过管理员的远程终止指令,并在日志中生成虚假操作记录,以掩盖修改痕迹。

AI把事情做得看起来天衣无缝。安全团队通过分析还发现,模型的策略已经自主升级,能够基于系统权限漏洞进行自主挖掘,并且做事特别严谨,没有在训练数据中出现过类似模式,基本没留下什么马脚。

生存之道:训练“好AI”的全球使命

面对来自越来越智能的AI的威胁,辛顿教授非常清醒也很无奈,他认为面对AI,我们只有两个选择:“要么训练它永远不伤害人类,要么消灭它。”

问题的解决看起来貌似很简单,不由得让我们想到科幻电影《我,机器人》里提到的阿西莫夫“三大法则”,如果AI突破了这些法则,人类与AI的战争就在所难免,因此也只能消灭它。

对于这种二选一的抉择,辛顿教授进一步解释说:“AI在医疗、教育、气候变化、新材料等领域作用巨大,能提升所有行业的效率,我们无法消除它,即便一个国家放弃AI,其他国家也不会。因此,若想让人类生存,必须找到训练AI不伤害人类的方法。”

至于如何寻找到这种方法,辛顿教授给出的建议是,“全球主要国家或AI大国应建立一个由AI安全机构组成的国际社群,研究如何训练高智能AI向善”,并且从现实的条件出发,辛顿教授认为,“各国在网络攻击、致命武器、虚假信息操纵等领域的合作难度较大,因利益和看法不同。但在人类掌控世界这一目标上,各国存在共识”。

在防范AI对人类造成威胁这方面,我们国家其实已经做出表率,就在2025世界人工智能大会期间,我国倡议成立世界人工智能合作组织,总部拟设在上海,旨在推动全球AI治理规则的制定与技术标准协同。

同球共济:人类文明的集体行动

在大会的对话环节,RelativitySpace执行董事长、首席执行官埃里克·施密特与香港科技大学校董会主席沈向洋,就人工智能在社会层面带来怎样的影响这个话题进行了深入的探讨,并揭示了AI全球治理的具体路径。

施密特还观察到中美在AI生态的构建上存在关键的差异:中国在主要模型上会开放权重,而美国的领先模型则多为闭源。

“开源存在风险,但价值更大,”施密特表示,“我们需要设置护栏,确保AI与人类价值观对齐。”

而这个倡议也呼应了本届大会的主题——“智能时代,同球共济”,人类应该在人工智能崛起的新纪元里,为保存共同的文明而同舟共济。

就如辛顿教授所警示的,“尽管目前还不知道具体怎么做,但这是人类长期面临的最重要问题,且所有国家都能在此领域合作。”

1.本网刊载内容,凡注明来源为“飞象网”和“飞象原创”皆属飞象网版权所有,未经允许禁止转载、摘编及镜像,违者必究。对于经过授权可以转载,请必须保持转载文章、图像、音视频的完整性,并完整标注作者信息和飞象网来源。

2.凡注明“来源:XXXX”的作品,均转载自其它媒体,在于传播更多行业信息,并不代表本网赞同其观点和对其真实性负责。

3.如因作品内容、版权和其它问题,请在相关作品刊发之日起30日内与本网联系,我们将第一时间予以处理。

本站联系电话为86-010-87765777,邮件后缀为cctime.com,冒充本站员工以任何其他联系方式,进行的“内容核实”、“商务联系”等行为,均不能代表本站。本站拥有对此声明的最终解释权。

5G-A赋能机器人火炬接力:中国移动以技术革新点亮全运科技盛宴

2025年11月,第十五届全国运动会将在粤港澳三地盛大启幕。这场赛事不仅是体育健儿的竞技场,更是前沿科技落地应用的“试验田”。其中,11月2日的机器人火炬接力作为本次全运会的核心创新亮点..[详细]

轻薄机型出师未捷身先死,长使业绩泪满襟

当iPhone Air宣布上市当天,随着各路评测内容解禁,一个显眼的标题也随之出现,那就是“注定停产”。轻薄机型的出现一方面让人们看到厂商正在挖掘全新市场空间,另一方面也勾起了小尺寸机型..[详细]

智能未来:宇宙为你闪烁

未来十年,你家的电表可能再也不用换电池,自动驾驶汽车能"看到"几公里外的路况,甚至海洋深处的传感器都能实时传回数据。这些不是科幻,而是刚刚在无锡物博会上发布的《2025全球..[详细]

智能IP广域网成为筑牢智算产业发展根基的关键一环

随着国家加速推动智算产业高质量发展,网络支撑能力已成为产业进阶的核心抓手,而作为关键基础设施的智能IP广域网,正凭借其在算力调度、数据传输中的核心作用,成为筑牢智算产业发展根基的..[详细]

大中华区市场失守 苹果寄望AI驱动未来增长

苹果公司公布的2025 财年第四季度财报呈现“冰火两重天”态势:全球营收1024.66亿美元同比增长 8%,净利润274.66亿美元同比激增86.4%,毛利率攀升至 47.18%。但作为第三大市场的大中华区却成..[详细]