快手Klear-Reasoner登顶8B模型 GPPO算法双效强化稳定性与探索能力

在大语言模型的竞争中,数学与代码推理能力已经成为最硬核的“分水岭”。从 OpenAI 最早将 RLHF 引入大模型训练,到 DeepSeek 提出 GRPO 算法,我们见证了强化学习在推理模型领域的巨大潜力。然而,想要复现这些顶尖成果,并不只是“多喂点数据、跑几轮训练”这么简单。现实是,很多中小规模的开源推理模型,在 AIME 这样的高难数学竞赛题、或 LiveCodeBench 这样的复杂代码评测中,依然与闭源 SOTA 存在明显差距。

最近,快手 Klear 语言大模型团队推出了全新的 Klear-Reasoner 模型,基于 Qwen3-8B-Base 打造,在数学与代码的多个权威基准测试中达到同规模模型的 SOTA 水平,并完整公开了训练细节与全流程 pipeline。

论文链接:https://arxiv.org/pdf/2508.07629

Hugging Face:https://huggingface.co/Suu/Klear-Reasoner-8B

GitHub:https://github.com/suu990901/KlearReasoner/tree/main

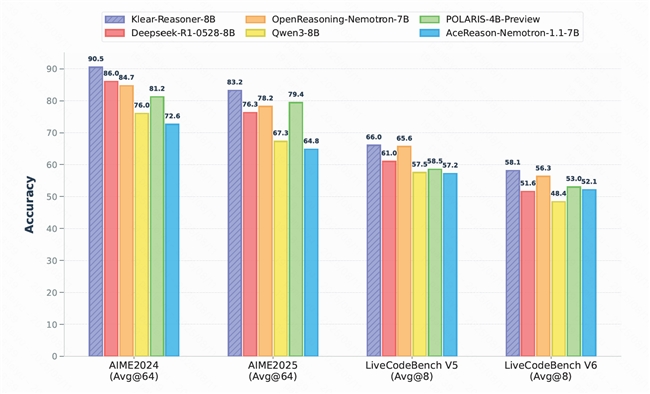

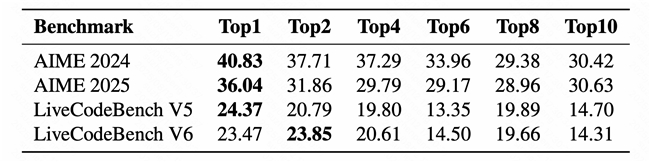

Klear-Reasoner 在 AIME2024、AIME2025、LiveCodeBench V5 和 V6 等基准测试中,不仅全面超越同规模的强力开源模型(包括 DeepSeek 蒸馏版 DeepSeek-R1-0528-8B),更是在 AIME2024 上取得了 90.5%、AIME2025 上取得了 83.2% 的惊人成绩,直接登顶 8B 模型榜首。

在这些成果的背后,最核心的技术创新是Klear团队提出的 GPPO(Gradient-Preserving Clipping Policy Optimization)算法 ——一种在保留训练稳定性的同时,大幅提升探索能力的强化学习优化方法。

传统clip的隐性代价

在PPO和GRPO等常用的策略优化方法中,clip是控制训练稳定性的重要手段,它通过限制策略更新幅度,避免模型一步走得太远而导致崩溃。Klear团队在实践中发现,clip 机制在保护稳定性的同时,也切断了模型获取最有价值学习信号的通道,模型变得保守,不敢尝试新路径,遇到错误也修正迟缓。

GPPO方法:保留梯度的“温和”方案

为解决以上问题,Klear团队提出的 GPPO(Gradient-Preserving Clipping Policy Optimization)算法,GPPO的核心思想很直接:不丢弃任何梯度,并且对其进行温和回传。通过 GPPO,推理模型可以在稳定性与探索力之间找到新的平衡点,让它们既敢于尝试,也能迅速纠错。

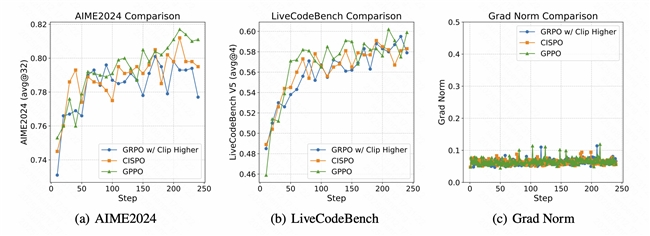

在与现有方法的对比中(包括DAPO的clip-higher以及MiniMax-M1的CISPO方法),GPPO在数学和代码任务上都表现出优势。

数学强化学习训练中GPPO、GRPO(带Clip Higher策略)与CISPO的对比。

实验洞察

除了提出GPPO算法外,Klear团队在论文中对训练流程的多个关键环节进行了深入实验与分析,揭示了长思维链推理模型成功背后的几个核心要素,为社区贡献了一条可复现、可推广的推理模型监督学习和强化学习路线:

·SFT阶段:质量优先,数据可靠性比数量更重要

实验表明,与数据量大但质量参差的数据源相比,来自少数高质量数据源的样本更具训练效率和效果优势。

高质量数学数据Top-K子集组合对监督微调(SFT)性能的影响。

·SFT阶段:高难样本容错反而能促进学习

对于简单任务,错误样本的引入会明显影响性能,但对于高难度任务,保留部分带瑕疵的推理路径,反而能够提升模型表现。

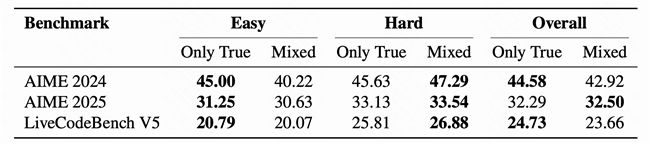

通过三组实验分析了数据正确性对模型性能的影响,分别在简单(Easy)、困难(Hard)和整体(Overall)任务集上对比了纯正确数据(Only True)与含错误数据的混合数据(Mixed)的表现差异。表格中加粗数值标识了各组内的最优性能结果。

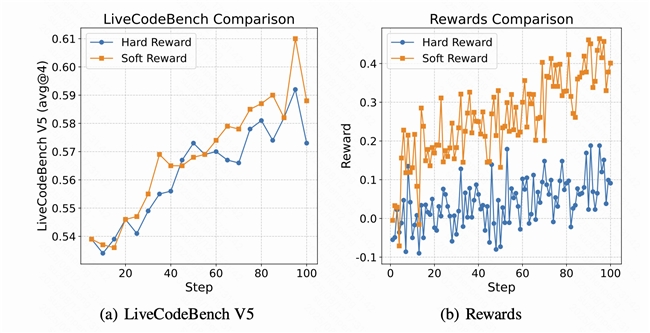

·RL阶段:软奖励优于硬奖励

在代码任务的强化学习阶段,使用软奖励(根据通过测试用例的通过率)比硬奖励(完全通过得分,否则为零)更有效

代码强化学习中软奖励与硬奖励策略的对比。在软奖励设置中,奖励值等于测试用例通过率;而在硬奖励设置中,仅当所有测试用例均通过时给予正向奖励,否则给予负向奖励。

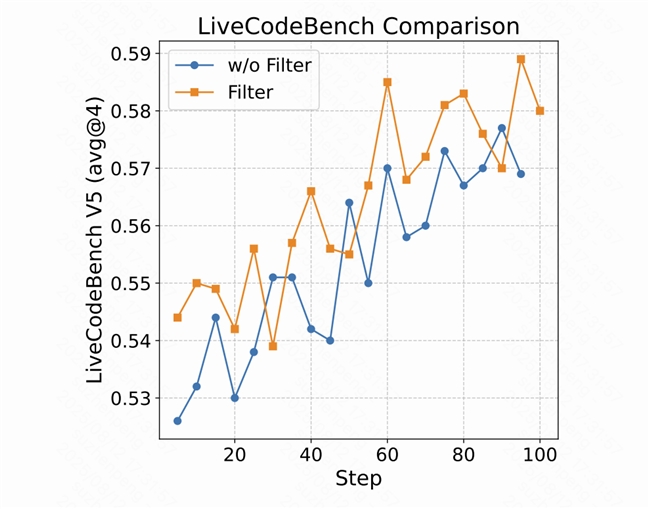

·RL阶段:代码数据测试用例过滤

在代码RL数据准备阶段,Klear团队调用DeepSeek-R1-0120为每个prompt生成了16条回复,只有pass@16大于0.5的数据会被保留

在LiveCodeBench V5基准(avg@4指标)上,使用过滤与未过滤数据的代码强化学习性能对比。Filter表示使用过滤数据的强化学习结果,而w/o Filter代表使用原始未过滤数据集的结果。

Klear-Reasoner 的推出,不仅是一份性能亮眼的开源权重,更为社区贡献了一条可复现、可推广的推理模型监督学习和强化学习路线。通过 GPPO,推理模型可以在稳定性与探索力之间找到新的平衡点,让它们既敢于尝试,也能迅速纠错。这对于未来的数学、代码,甚至其他RLVR任务,都有着重要的参考价值。

1.本网刊载内容,凡注明来源为“飞象网”和“飞象原创”皆属飞象网版权所有,未经允许禁止转载、摘编及镜像,违者必究。对于经过授权可以转载,请必须保持转载文章、图像、音视频的完整性,并完整标注作者信息和飞象网来源。

2.凡注明“来源:XXXX”的作品,均转载自其它媒体,在于传播更多行业信息,并不代表本网赞同其观点和对其真实性负责。

3.如因作品内容、版权和其它问题,请在相关作品刊发之日起30日内与本网联系,我们将第一时间予以处理。

本站联系电话为86-010-87765777,邮件后缀为cctime.com,冒充本站员工以任何其他联系方式,进行的“内容核实”、“商务联系”等行为,均不能代表本站。本站拥有对此声明的最终解释权。

5G-A赋能机器人火炬接力:中国移动以技术革新点亮全运科技盛宴

2025年11月,第十五届全国运动会将在粤港澳三地盛大启幕。这场赛事不仅是体育健儿的竞技场,更是前沿科技落地应用的“试验田”。其中,11月2日的机器人火炬接力作为本次全运会的核心创新亮点..[详细]

轻薄机型出师未捷身先死,长使业绩泪满襟

当iPhone Air宣布上市当天,随着各路评测内容解禁,一个显眼的标题也随之出现,那就是“注定停产”。轻薄机型的出现一方面让人们看到厂商正在挖掘全新市场空间,另一方面也勾起了小尺寸机型..[详细]

智能未来:宇宙为你闪烁

未来十年,你家的电表可能再也不用换电池,自动驾驶汽车能"看到"几公里外的路况,甚至海洋深处的传感器都能实时传回数据。这些不是科幻,而是刚刚在无锡物博会上发布的《2025全球..[详细]

智能IP广域网成为筑牢智算产业发展根基的关键一环

随着国家加速推动智算产业高质量发展,网络支撑能力已成为产业进阶的核心抓手,而作为关键基础设施的智能IP广域网,正凭借其在算力调度、数据传输中的核心作用,成为筑牢智算产业发展根基的..[详细]

大中华区市场失守 苹果寄望AI驱动未来增长

苹果公司公布的2025 财年第四季度财报呈现“冰火两重天”态势:全球营收1024.66亿美元同比增长 8%,净利润274.66亿美元同比激增86.4%,毛利率攀升至 47.18%。但作为第三大市场的大中华区却成..[详细]